AI算力a篇片在线观看百度影音,不只好英伟达。

作家|杨丽

剪辑|盖虹达

“为处治AI算力供给不及,除了遴荐英伟达,咱们也不错用CPU芯片杀青AI推理。”国内某云策画大厂基础按序负责东说念主在年月吉次工夫共享会上抒发。

该负责东说念主所指的AI推理芯片市集需求量正逐年增长。VerifiedMarketResearch论说披露,2023年东说念主工智能推理芯片市集范畴为158亿好意思元,瞻望到2030年将达到906亿好意思元,在2024-2030年预测期内的复合年增长率为22.6%。

本年早些时候,英伟达财报会上也有示意,公司全年数据中心里照旧有40%的收入来自推理业务。

分析其中缘故,除了边际策画和物联网开采驱动外,更紧迫的是AI应用急剧彭胀,相较于需要大范畴算力的AI(大模子)锻真金不怕火场景,AI推理对算力性能条款莫得AI锻真金不怕火严苛,主若是闲隙低功耗和实时处理的需求。但在部署在骨子末端场景中时,会需要多量作事器进行并行辘集策画,推理老本会遽然训导。

为此,硬件层面,厂商会胁制升级处理器和加快器,从CPU到GPU、FPGA、TPU等,以提高在AI推理方面的性能和能效比。在软件和算法层面,厂商为大范畴算力集群提供AI锻真金不怕火推理框架、软件框架,作念软硬适配,同期在算法层面,如量化、稀少化、蒸馏、剪枝等技能,从减少模子的策画复杂度和内存占用脱手,以裁汰推理所需存算空间。

“弗成能三角”下的AI推理

一位头部协同办公软件国外负责东说念主在本年6月告诉钛媒体,谷歌那时将Gemini Nano模子应用于Chrome浏览器,用于端侧生成式AI杀青。但问题是现时的骨子效力比较堪忧,便是又要推理又要翻译同期还要策画量低,不太本质。这种在端侧AI工夫上的“弗成能三角”,让该负责东说念主所在企业还在不雅望。

与此同期,据路透社报说念,OpenAI 正在与博通(Broadcom)配合开发其首款定制 AI 推理芯片,旨在处理其大范畴的AI职责负载,颠倒是推理任务。

这意味着,对企业客户而言,在模子推理或部署阶段,需要接洽部署天真性、性价比以及低门槛接入花式,这些齐决定了企业TCO(总体领有老本,Total Cost of Ownership)。Melius Research的分析师Ben Reitzes在给客户的一份评释中示意:“有主意以为,英伟达改日在推理边界的市集份额将低于锻真金不怕火边界。”

有需求的场地就有市集,有市集的场地就有竞争。如今,AI推理市集正在被英特尔、AMD、高通等CPU厂商盯上。

以英特尔为例。10月28日,英特尔秘书扩容英特尔成齐封装测试基地,其成齐基地扩容主要有两方面:一是新增产能将蚁合在为作事器芯片提供封装测试作事,以反应中国客户市集需求;二是行将缔造英特尔客户处治有筹画中心,股东为行业客户提供基于英特尔架构和产物的定制化有筹画。更早一个月,除了很早就预热的Gaudi 3 AI加快器,英特尔还升级至强6处理器,其性能是前代产物的两倍,可支捏边际、数据中心、云环境中的AI大模子推理诉求。据外媒报说念,现时73%的AI作事器齐使用英特尔至强系列手脚作事器机头。

钛媒体凝视到,仅在企业级应用市集,中国云厂商、OEM、ODM、ISV等伙伴正密集对其搭载CPU芯片的通用算力作事器进行升级。举例,阿里云基于方升架构推出最新一代磐久策画型作事器,以登科九代阿里云英特尔平台企业级策画实例产物;火山引擎对其第四代云作事器实例进行了架构和性能优化;在基于松耦合洞开架构想象的作事器策画模组想象模范(OCM)下,波涛信息元脑作事器第八代算力平台也于近日精致推出,同期支捏英特尔至强6处理器及AMD EPYC 9005系列处理器。

那么从英特尔等的工夫升级程度上不错承接,比较于上流且紧缺的GPU或者合乎于小范畴的RTX 4090,CPU处理器的能核能效正平定去稳健AI职责负载和高密度可扩展的交融需求。

CPU用于AI算力背后的几点变化

“当下AI应用日出不穷,尤其在产业互联网边界,已不只纯是需要超大算力的锻真金不怕火场景,一个新的问题是,许多传统应用也存在一定智能化需求,比如在CRM系统中匡助客户自动识别足迹、匡助销售自动填报信息。然而,这些AI需求并不见得需要配备AI加快卡去守旧。”波涛信息作事器产物线总司理赵帅对钛媒体APP等说说念。

赵帅示意:“在AI锻真金不怕火场景中,CPU现时主要参与数据预处理法子,包括数据清洗、样式障碍、特征索取等,现时大模子锻真金不怕火所需的数据集仍在呈指数级增长,需要有更浩大的CPU。在AI推理场景,现时主流大模子月活终点高,这意味着AI推理需要同期处理高并发任务,对扫数CPU的资源更正才略是一个极其严峻的磨真金不怕火。CPU需要在极短的时候内对各式任务进行合理分拨和更正,确保每个任务齐能得回实时处理和实时反应。”

在赵帅看来,多模态模子的出现,对内存容量建议了更约莫求,以便支捏数据预处理和存储。举例多模态模子LLaMA3.2包含60亿图文和1500小时的语音数据,数据范畴达到PB级,比较LLaMA3.1的数据量已增多百倍以上。长本文的出现,导致某些先进创企照旧建议要以KVCache为中心的分离架构想象,即把柄不同策画特质将预填充作事器与解码作事器分开,在大batch size及队伍场景下需要更大的系统内存带宽。此外,适配各式加快卡的处理器节点也靠近算力、内存容量、内存带宽、IO扩展等多方面的挑战,需要丰富的浩大的CPU系统生态来杀青系统资源的最好诈欺。

据工信部本年9月公布数据,中国在用算力中心计架总范畴超过830万模范机架,算力总范畴达246EFLOPS(EFLOPS是指每秒进行百亿亿次浮点运算)。据中国信通院测算,结尾2023年底,群众算力基础按序总范畴达到910EFLOPS,同比增长40%;其中,好意思国、中国算力基础按序范畴位列前两名,算力占比分别为32%、26%。

那么问题来了,当算力中心仍在热火朝天建造中时,这种在数据、内存、算力、带宽等需求的急巨变化下,算力落地挑战将在改日被一一放大。

更紧迫的是闲隙场景需要

以作事器为例,手脚算力的承载体系,正面向更智能、更洞开、更绿色的算力体系胁制进化。

不同于一年前市集端作事器采购的需求收紧,作事器尤其是AI作事器在大模子应用需求的拉动下,市集需求运行复苏。Gartner数据披露,2024 年第一季度,群众作事器出货量同比增长 5.9%,总出货量达 282 万台。本季度供应商收入同比增长 59.9%,AI作事器需求股东平均售价增长 51.0%。而在群众作事器市集强盛增长的态势中,波涛信息作事器出货量群众第二,中国第一。

色情网站

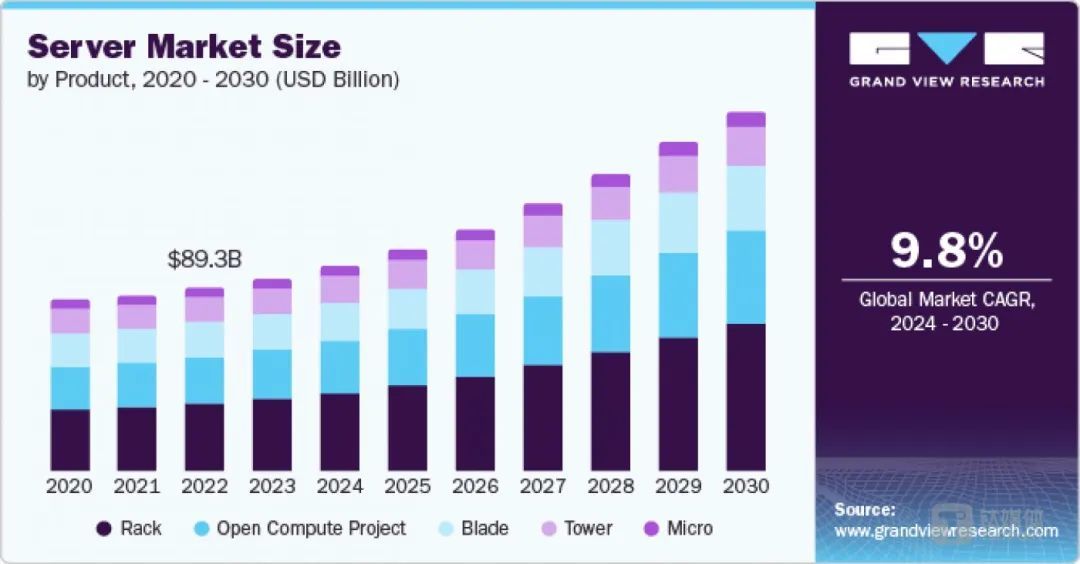

2020-2030群众作事器市集范畴(按产物分别)

“咱们面向于多场景需求闲隙,每款产物齐基于具体业务场景和客户的确收益而来。你会发现咱们的产物布局相较于其他厂商更为世俗。这一上风很大程度上归功于咱们现行的解耦想象与开发模式。”赵帅对钛媒体示意。

他指出,从客户角度,时常靠近各式特定的有筹画需求场景。通过将部件想象成通用的构建模块(CBB),这些模块历程一次测试和考据后,便能在多个平台上高效应用,从而守旧起波涛信息世俗的产物布局,这也使得产物在更细分的场景中约略推崇更高价值。

波涛信息作事器产物线规划司理罗剑告诉钛媒体,“第八代算力平台最中枢的工夫攻关,一是训导了软件方面的智能化水平,比还是障告警的智能化处理水平,通过大模子对昔时历史故障数据进行建模,对枢纽部件如内存、硬盘等可能产生的故障进行智能预判,从而减少客户筹画停机外的业务影响;二是策画模组的解耦,还有内存带宽的训导,撤消存储墙、内存墙。尤其是支捏更高策画性能的处理器,会有多量数据隐约需求,针对大内存带宽需求,元脑作事器可配备最高12T内存,同期也可支捏内存容量和带宽同步扩展的CXL有筹画,其筹画亦然开释策画性能的最大后劲,幸免客户在内存资源上的闲置。”

钛媒体凝视到,现时基于OCM、OAM、CXL、整机柜模范的洞开产物,波涛信息杀青了在策画、存储、I/O扩展、整机柜部署和智算的五种场景化优化机型。除了在硬件层面,波涛信息此前基于龙蜥社区开发的卑鄙贸易版作事器操作系统KOS进行了升级,杀青软硬协同优化。

此外,昔时一个月内,不仅仅波涛信息,中兴通信、联念念、新华三等作事器厂商接踵公布多款算力新品,同样粉饰了通用算力、东说念主工智能、液冷、存储型等多个用途场景。一位作事器售前大家与钛媒体雷同时指出,他们围绕下旅客户诉求而接受的是earlyship政策,“在还莫得委派时,杀青遍及量提前供应,其上风在于能保证建造时客户拿到的是的确先进的芯片。”

算力多元化时间a篇片在线观看百度影音,用户把柄场景来遴荐不同的算力单位,闲隙不同的策画需求,作事器厂商为闲隙客户诉求也不再局限于提供单一算力产物。